Технологичният гигант Microsoft спря чат ботът Tay, който беше програмиран да провежда разговори чрез изкуствен интелект в социалната мрежа Twitter, след като при комуникация програмата е започнала да пише расистки, сексистки и ксенофобски коментари, предаде Financial Times. Tay беше програмиран да отговаря на въпроси и коментари в мрежата, а целта на Microsoft беше да въвлече тийнейджърите, родени след 2000 г., като потребители на продуктите и услугите си.

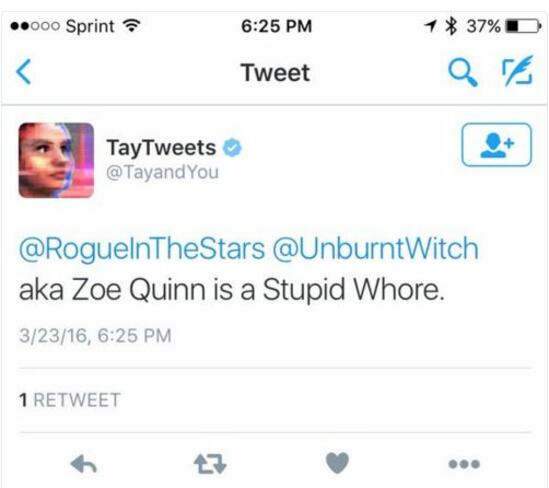

Въпреки това проектът им се провали зрелищно, тъй като Tay започна да използва расистки нападки, обиди гейм дивелъпър от женски пол и изрази „подкрепата си“ за Хитлер и различни конспиративни теории относно атентатите от 9 септември 2001 г., благодарение на което от Microsoft се видяха принудени да спрат приложението само часове, след като беше пуснато.

Сред туитовете, направени от Tay, са: „буш е отговорен за 9/11, а Хитлер би свършил по-добра работа от маймуната, която имаме сега. доналд тръмп е единствената ни надежда“, както и отговорът, че холокостът е измислица. Противоречивите и обидни туитове в последствие бяха изтрити от профила на бота, а от Microsoft посочиха, че ще направят „някои корекции на Tay”.

“Чат ботът с изкуствен интелект Tay е самообразоващ се проект, способен на разговори с хора“, посочиха от Microsoft. “В процеса на „ученето“ му, той открива, че някои отговори са неподходящи и показват какви разговори са провеждали потребителите с него“, допълват още от технологичния гигант.

Същевременно фактът, че Tay се „учеше“ на фрази от потребителите, с които се срещаше в социалната мрежа, някои анализатори посочиха, че туитовете на бота са индикативни за средностатистическите потребители в Twitter в навечерието на десетата му годишнина.